算力突破|范式FuseSpill技术或提升最高40%推理速度 获著名国际学术期刊IEEE收录

日前,由范式技术团队参与编写的学术论文《FuseSpill:高效管理大模型推理中的显存溢出》被国际著名学术期刊《IEEE Transactions on Parallel and Distributed Systems》(TPDS)正式接收。该研究提出了一种创新的显存管理技术,破解了大模型推理的算力瓶颈,为实现高效、普惠的AI计算提供了全新路径。预计相关能力将在未来1-2年内逐步集成到企业级和消费级AI产品中,让普通用户也能亲身体验“高智能、不卡顿”的AI应用。

期刊权威性

IEEE TPDS是并行与分布式计算领域公认的期刊,以其严格的审稿标准和对前沿技术趋势的深度洞察著称,收录的研究成果代表全球计算机系统领域的最高水平。

FuseSpill能够在其中亮相,标志着其在系统架构与资源调度方面具备行业领先的创新价值。

01 大模型撞上“显存墙”

我们在面临什么?

显存溢出:当显卡内存不足时,系统将部分数据转移到速度更慢的CPU内存中,导致计算效率急剧下降的现象

“显存溢出”并不仅是技术术语,它真实影响着每一个想使用AI的普通人——当你与智能助手对话、生成一篇文章或一幅画时,如果显卡内存不足,AI的反应会明显变慢,甚至直接“卡住”。这堵“显存墙”已成为大模型普及的瓶颈:

行业瓶颈:若无法解决显存溢出,大模型将只能依赖少数高端显卡,部署成本居高不下,技术普及速度受阻

用户痛点:普通用户即便拥有主流配置的电脑或手机,在使用AI写作、翻译、问答等应用时,仍可能频繁遭遇响应迟缓、任务中断等糟糕体验

02 FuseSpill如何实现“显存突围”?

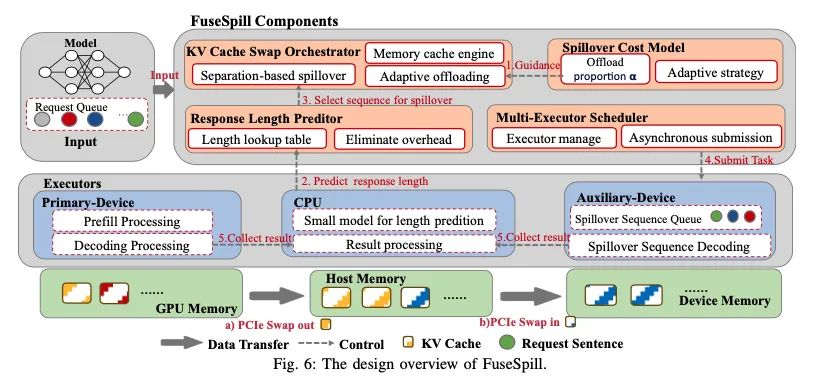

FuseSpill借鉴了“分工协作”的智慧。它发现大模型的运行可分为两个阶段:

Prefill阶段(理解输入):计算密集,需快速处理完整输入序列,但显存占用较少

Decode阶段(生成输出):计算量小,但需持续存储生成的令牌序列,显存占用持续累积

FuseSpill创新地将这两个阶段拆解,构建异构计算架构:

主显卡(高性能GPU)专注Prefill阶段的高强度计算

辅助计算单元(其他GPU或CPU)接管Decode阶段的显存密集型任务

这就好比一个双引擎智能赛车系统:

起步加速时,高性能主引擎全功率输出,快速达到工作速度

巡航阶段,节能副引擎接管维持任务,主引擎进入待机准备下次加速

通过这样的“动静分离”,FuseSpill让每一份算力都用在刀刃上,实现真正的高效与稳定。

03 实测效果与行业价值

在实际测试中,FuseSpill让主流大模型在消费级显卡上实现了:

性能提升:推理速度最高提升40%

成本优化:千元级显卡也能获得近似高端卡的流畅体验

普适性强:适用于多种硬件配置,显著降低大模型部署门槛

而对普通用户而言,这项技术意味着什么?

未来,你或许可以在自己的笔记本电脑上:

流畅使用AI助手撰写报告、生成创意内容

实时进行多语言翻译与视频自动剪辑

甚至在游戏中与高度拟人的AI角色自由对话

FuseSpill让大模型,变成每个人设备中“触手可及”的智能伙伴。预计未来两年内,搭载该技术的AI应用将逐步落地,带来更便宜、更流畅、更个性化的AI体验。

04 未来展望

这项研究成果不仅为大模型部署提供了新的技术方案,更为整个AI行业的基础设施建设提供了参考。在算力需求持续增长的背景下,FuseSpill所代表的精细化资源管理理念,将助力更多企业和开发者以更低成本享受大模型技术的红利,直观感受到:AI应用响应更快、功能更强大,但硬件成本显著下降——大模型不再是“云端特权”,而是每个人设备中的“标准配置”。