可观测性下一站:从“数据堆砌”到“故障线索”的智能提炼

随着金融数字化转型的深入推进,IT架构日趋复杂分布式与微服务化,尽管各企业已逐步构建可观测能力体系,但实际故障排查仍面临严峻挑战。当前主要问题在于,可观测数据尚未形成以故障场景为核心的统一分析视角,其整合仍停留在基于拓扑的监控、日志、链路与告警数据的表层关联层面,粗粒度的数据聚合难以从海量信息中提炼有效线索,导致排查过程仍依赖个人经验,告警噪音难收敛,根因定位周期长,排障效率难以保障。

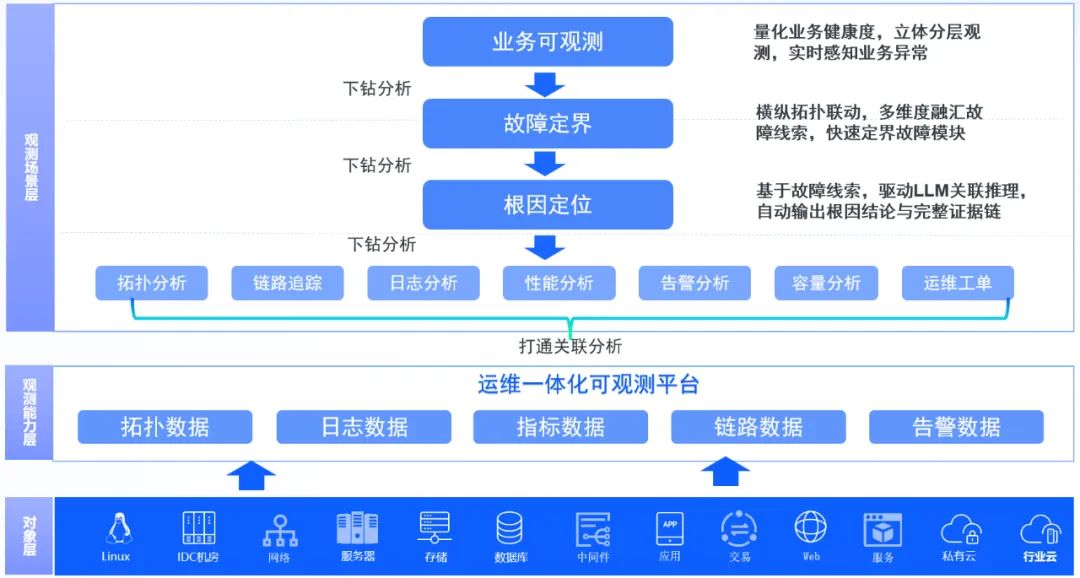

优云可观测平台实现理念升级:核心目标从简单呈现数据转变为智能提炼"故障线索",实现了从被动监控到主动洞察的转变。平台以动态拓扑为框架,智能算法为核心,将碎片化信息转化为系统化排障路径,帮助运维团队从信息过载中解脱,提升故障定位效率。

优云可观测逻辑架构图

横纵拓扑联动,构建定界闭环

分布式架构下的故障定界,核心挑战在于快速区分故障是内生性、传导性还是依赖性的。关键在于融合横纵两种拓扑视角:横向拓扑用于广谱筛查,回答“故障点在哪里”,迅速收敛问题范围;纵向拓扑用于垂直溯源,揭示“故障为何发生”,直指底层根因。二者结合,构成了从定位到溯源的定界闭环,从而精准切中间题要害。

横纵拓扑联动,构建定界闭环

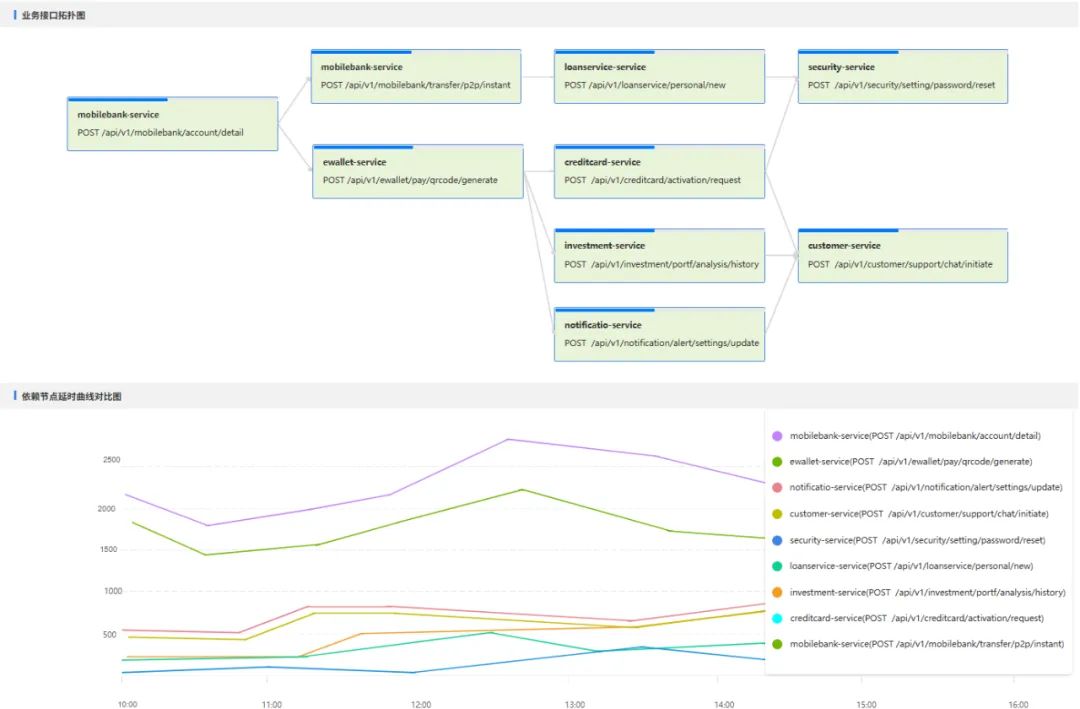

拓扑粒度细化至“接口级”,实现精准洞察

传统应用拓扑仅能粗粒度展示服务间依赖关系,难以精准定位具体接口层面的问题而而单条链路数据又缺乏统计意义,易将偶发噪声误判为系统性风险。为此,优云平台通过聚合分析API调用链信息,动态构建“接口级“拓扑,将可观测性从“服务层面”深入到“接口层面”,实现接口级依赖关系与性能指标的精细化分析。

多维度融汇故障线索,重塑根因分析流程

应对海量可观测性数据造成的信息过载,优云平台依托智能算法,实现了从“原始数据”到“故障线索”的自动提炼。通过错误日志聚类分析与特征挖掘,识别潜在故障模式;利用性能指标动态基线异常检测,实时捕捉系统偏离;并对关联告警进行收敛溯源,有效过滤噪音。最终,这些分析成果被整合为精炼的故障线索报告,将碎片化信息转化为清晰的排障路线图,显著加速从现象到根因的定位过程。

场景一 快速识别“服务自身故障”or“服务级联故障”

挑战 级联故障中,单一服务故障沿调用链扩散,产生复杂多变的现象,容易误判排查方向。

方案

1.接口拓扑构建 自动生成执行具体某类业务的URL级别路径拓扑。

2.曲线相似度分析 人工从拓扑图众多服务中定位最可疑的服务节点很难,我们只需要对比当前服务与依赖服务的延时、错误率曲线,按曲线相似度进行排序,相似度越高越可疑。若发现当前服务的异常曲线与某个上游服务高度相似,则可将故障源定位至该上游服务;若与所有上游曲线均不相似,则故障可能源于当前服务自身。

URL接口级拓扑图

场景二 精准区分“应用程序故障” or “应用依赖故障”

挑战 应用故障(如代码Bug)与依赖故障(底层网络丢包)常表现为相似症状(如接口超时、报错),形成“同象异因”的排查困境,易导致排障方向错误。

方案 通过构建纵向穿透的依赖拓扑视图,对关联的日志、链路、指标、告警等全量可观测数据进行关联分析,将原始数据转化为结构清晰、指向明确的“故障线索”,集中展示在一个页面上,辅助运维人员进行精准定界,有效规避误判,提升排障效率。

1. 动态构建纵向依赖拓扑

从故障接口精准锚定,逐层下钻穿透服务实例、容器Pod、操作系统直至底层宿主机与网络设备,完整映射从业务到基础设施的依赖路径。

2. 基于拓扑的故障线索智能分析

沿着纵向依赖拓扑,智能关联分析多维数据,聚合生成指向性明确的故障线索。包括:

错误日志线索:聚合分析业务接口错误日志,通过归类统计与关键信息提取,形成错误摘要,直观展示错误类型分布。构建错误特征库,实现错误堆栈的结构化归因与影响标记,将零散错误信息转化为结构化知识。结合历史基线对比,识别异常错误突增,过滤非关键噪音,聚焦真实故障信号。

关联告警线索:通过纵向拓扑扫描聚合跨层告警,形成故障全栈视图;在此基础上进行时间线分析,揭示告警时序与传播路径;结合错误日志关联验证,精准聚焦引发业务问题的关键告警,完成根源定位。

性能指标线索:智能关联告警信息,聚焦异常性能趋势,通过与历史基线的可视化对比,快速定位系统性能瓶颈。

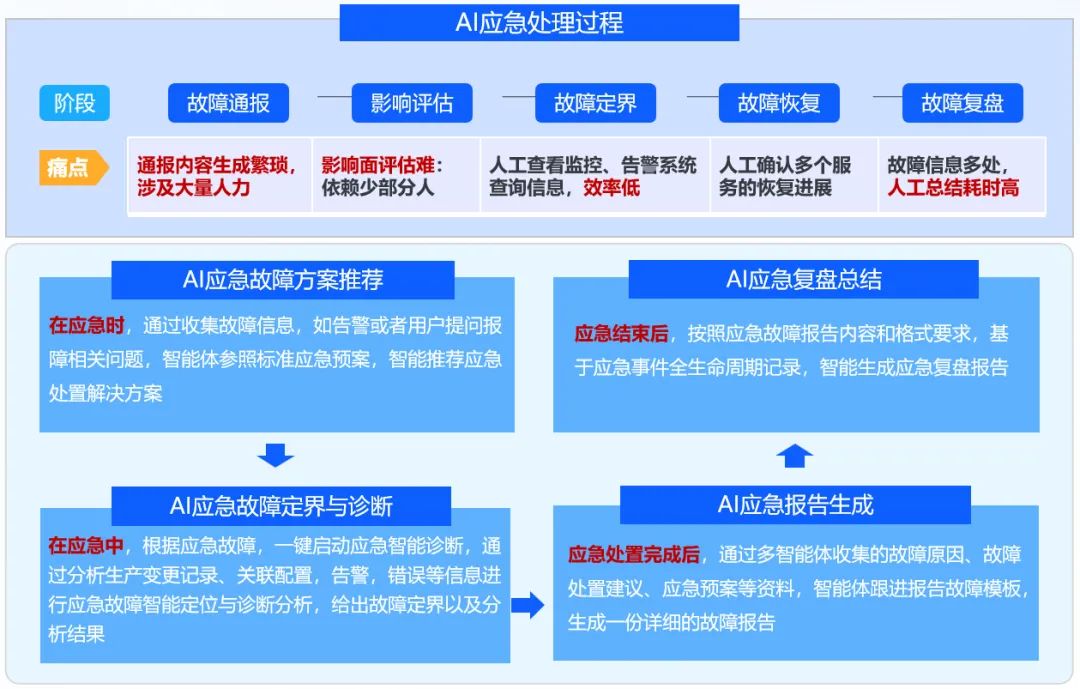

基于大模型的故障诊断分析

当前,平台已能通过“故障线索”有效提纯数据,但最终的根因判定仍依赖人工研判。优云正致力于引入大语言模型作为智能决策核心,以突破这“最后一公里”的瓶颈。我们可以将提炼后的故障线索,转化为运维大模型可深度理解的结构化上下文,使大模型能够模拟顶尖专家的推理模式,实现对多维线索的关联分析与综合研判,自动输出高可信度的根因结论及清晰的逻辑链。同时自动关联并呈现所有支撑结论的底层证据,实现“结论即证据”的无缝验证体验,最终构建一个从线索感知、智能推理到决策验证的完整自治化诊断闭环。